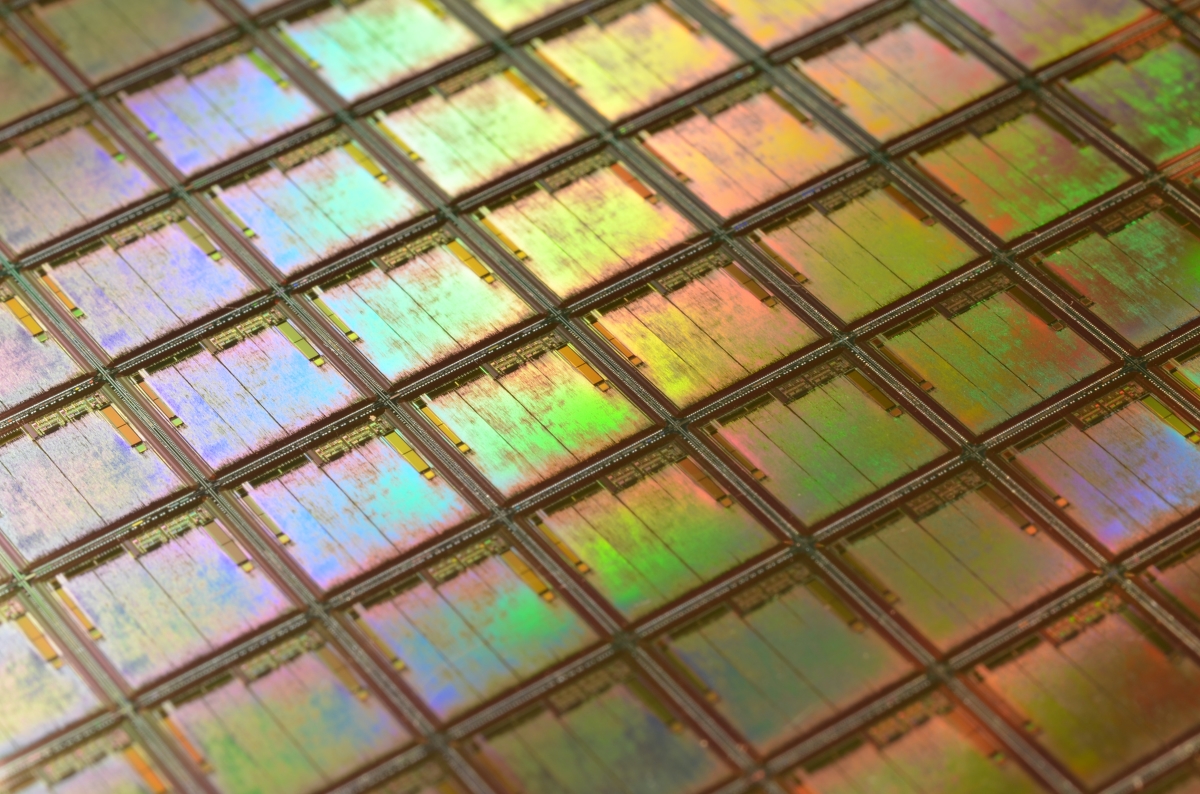

Lo scenario mondiale delle tecnologie legate all’intelligenza artificiale è in costante evoluzione, e le principali aziende del settore lavorano alacremente per innovare e mantenere la propria posizione di leadership nel mercato. Tra queste spicca, senza dubbio, Nvidia, azienda con sede in California, che ha recentemente annunciato, durante una conferenza, la creazione di un nuovo processore, il GH200, destinato a rivoluzionare ulteriormente il mondo dell’IA.

“Stiamo dando una spinta a questo processore”, ha affermato il CEO di Nvidia, Jensen Huang, sottolineando che il chip è stato progettato per il cosiddetto “scale-out” dei centri dati di tutto il mondo. Con una quota di mercato dell'80%, Nvidia è attualmente il leader indiscusso nel campo dei chip per l’intelligenza artificiale, grazie alle sue unità di elaborazione grafica (GPU) che hanno reso possibile lo sviluppo di modelli di IA di grandi dimensioni, come Google Bard e ChatGPT di OpenAI.

Tuttavia, le GPU Nvidia sono sempre più difficili da reperire a causa della crescente domanda da parte di giganti tecnologici, fornitori di servizi cloud e startup impegnate nello sviluppo di modelli di intelligenza artificiale. La presentazione del nuovo chip GH200, che prevede la stessa GPU del modello H100 - attualmente il chip più avanzato dell’azienda - mira a rispondere a queste esigenze, grazie all’aggiunta di 141 gigabyte di memoria e un processore centrale ARM a 72 core.

L’obiettivo principale del GH200 è di migliorare il processo di inferenza, ovvero la fase in cui i modelli di intelligenza artificiale vengono utilizzati per fare previsioni o generare contenuti. A differenza della fase di training, che implica l’analisi di enormi quantità di dati e richiede mesi di calcoli intensivi, l’inferenza si svolge continuamente ogni volta che il software viene messo in funzione, ad esempio per generare testi o immagini.

Grazie alla maggiore capacità di memoria del nuovo chip, pari a 141GB rispetto agli 80GB del modello H100, sarà possibile ospitare modelli di IA di dimensioni maggiori all’interno di un singolo sistema. Inoltre, Nvidia ha annunciato di avere in cantiere un sistema che unisce due chip GH200 in un unico computer, al fine di supportare modelli ancora più grandi.

Le novità introdotte da Nvidia sono ancora più interessanti alla luce della crescente competizione nel settore dei chip per l’intelligenza artificiale. Tra i principali concorrenti figura AMD, con il suo recente MI300X - un chip con 192GB di memoria progettato per il calcolo intensivo e l’inferenza - e aziende del calibro di Google e Amazon, che stanno lavorando a soluzioni proprietarie basate su chip customizzati per l’IA.

Il GH200 di Nvidia costituisce dunque un passo fondamentale nella “corsa all’oro” dei chip per l’intelligenza artificiale, dimostrando la determinazione dell’azienda nel mantenere la propria supremazia in un campo in costante espansione. La novità rivelerà tutta la sua portata solo nei prossimi mesi, quando il chip sarà disponibile per il mercato tramite i distributori di Nvidia a partire dalla seconda metà del 2022. Nel frattempo, l’attenzione degli esperti e degli appassionati di tecnologia sarà sicuramente catalizzata dall’evoluzione di questo chip che promette di apportare un contributo importante al futuro dell’intelligenza artificiale.

Cosa ne pensi?

Mostra l'area commenti